Expert Mistral

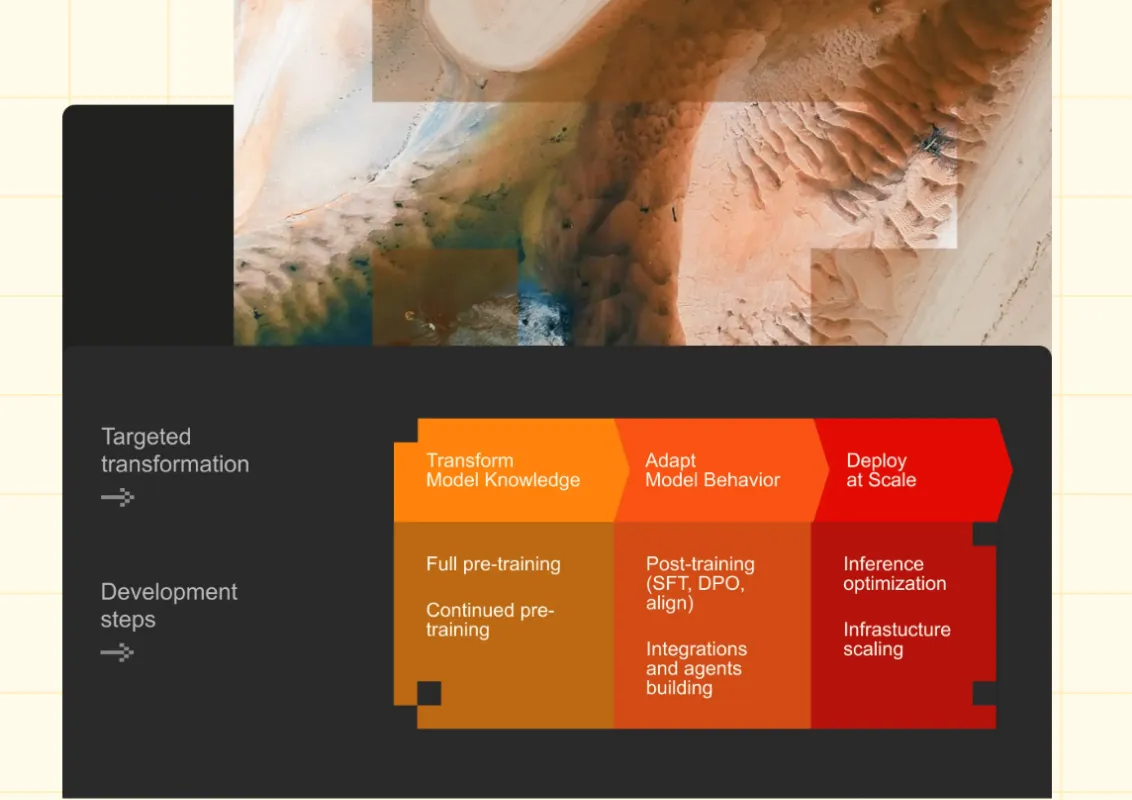

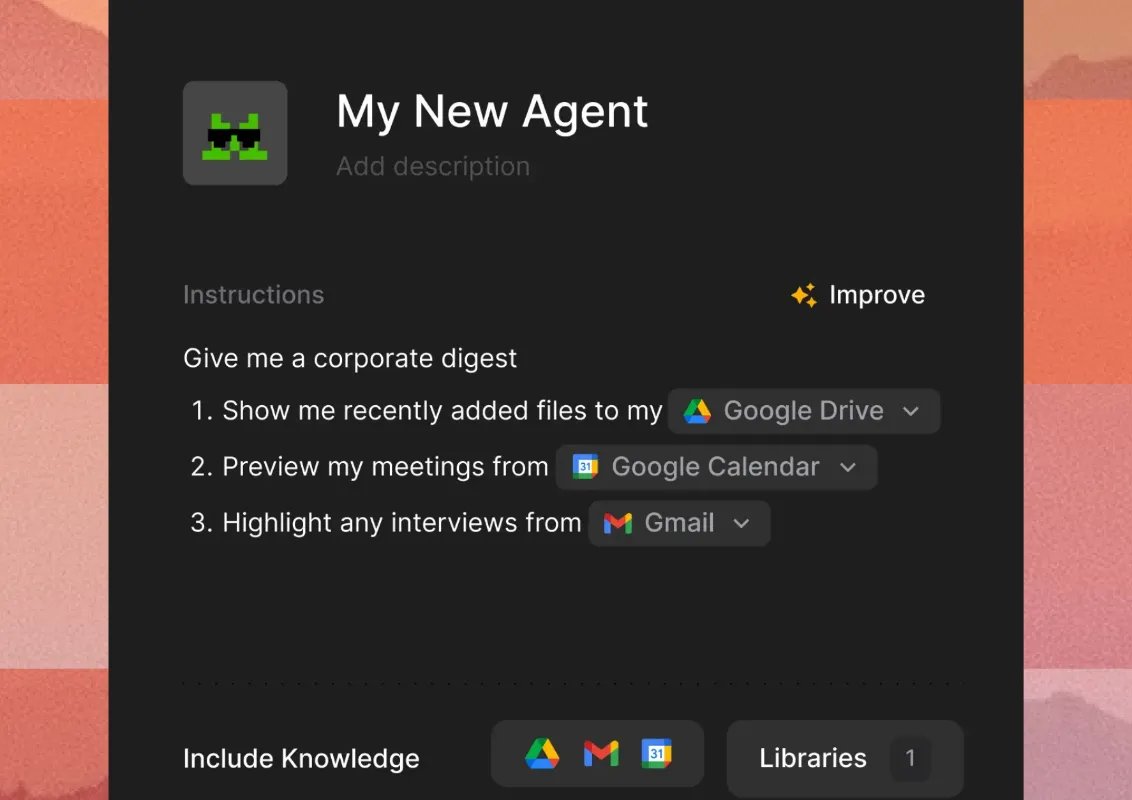

Nous implémentons les modèles Mistral pour doter vos applications d'une IA européenne souveraine et performante.

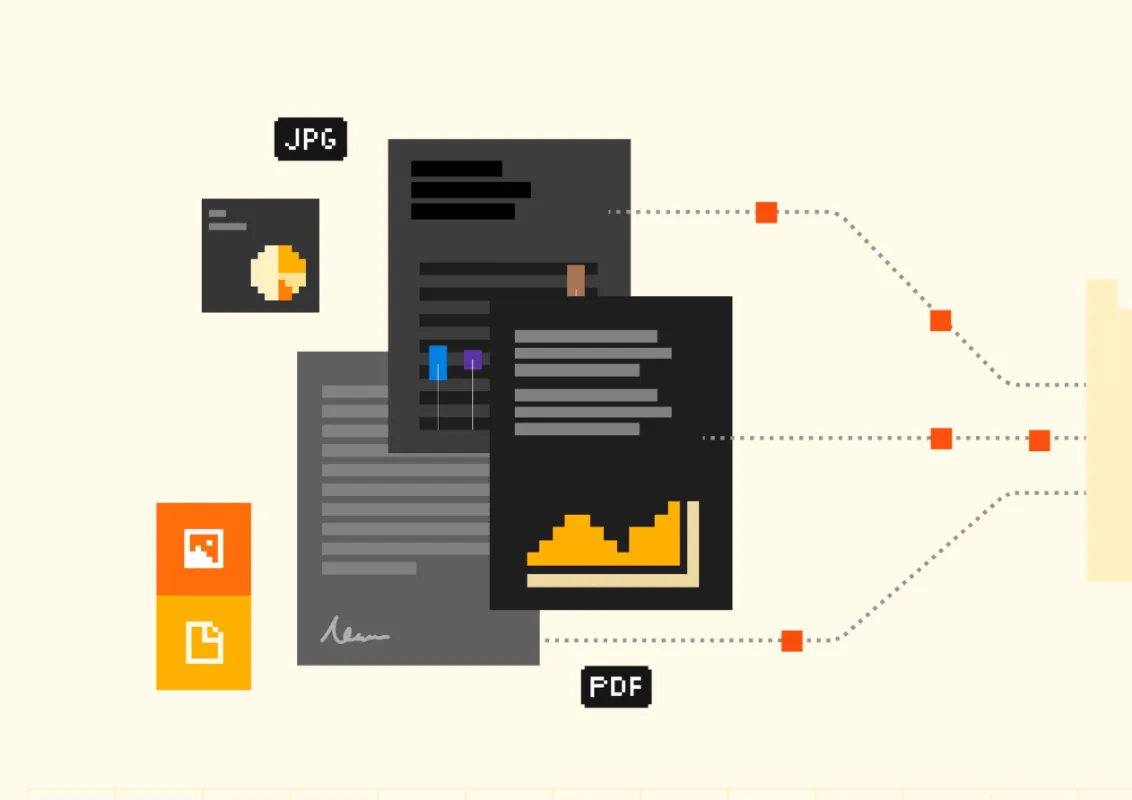

Mistral AI propose des modèles de langage optimisés offrant un équilibre parfait entre performance et efficacité, avec une approche open-source qui garantit transparence, souveraineté des données et adaptation précise à vos besoins spécifiques.