Expert Qdrant

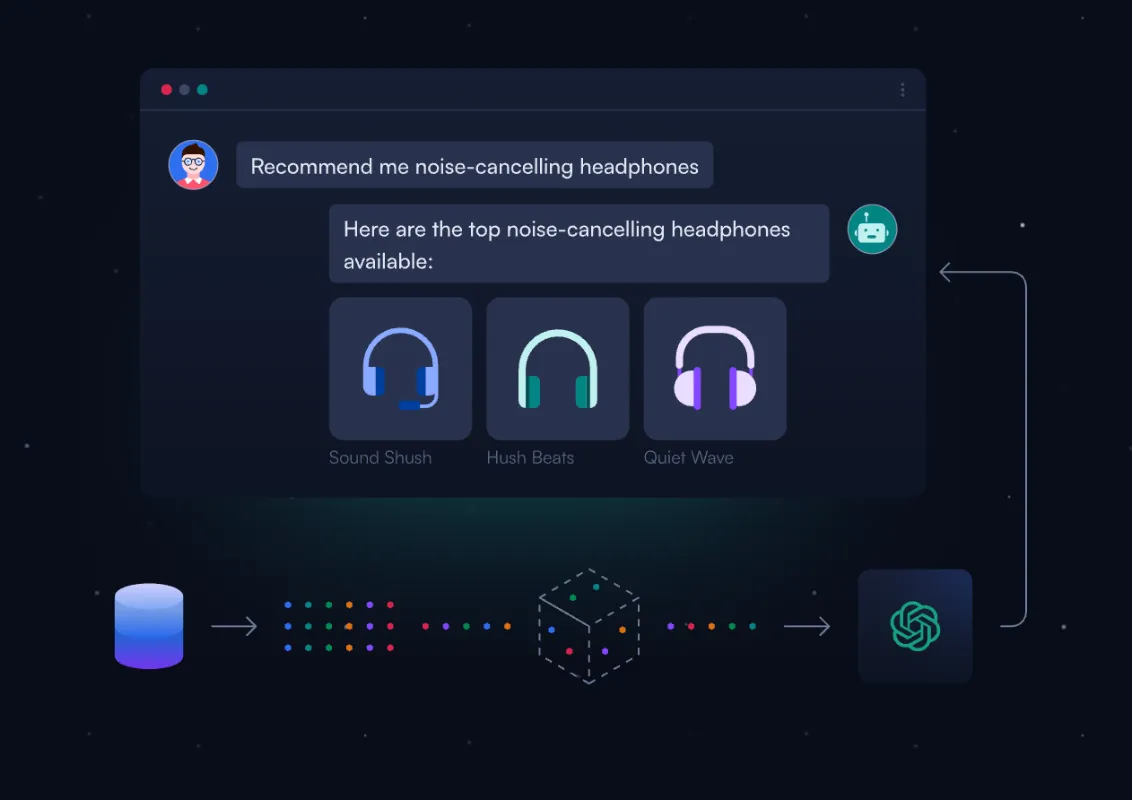

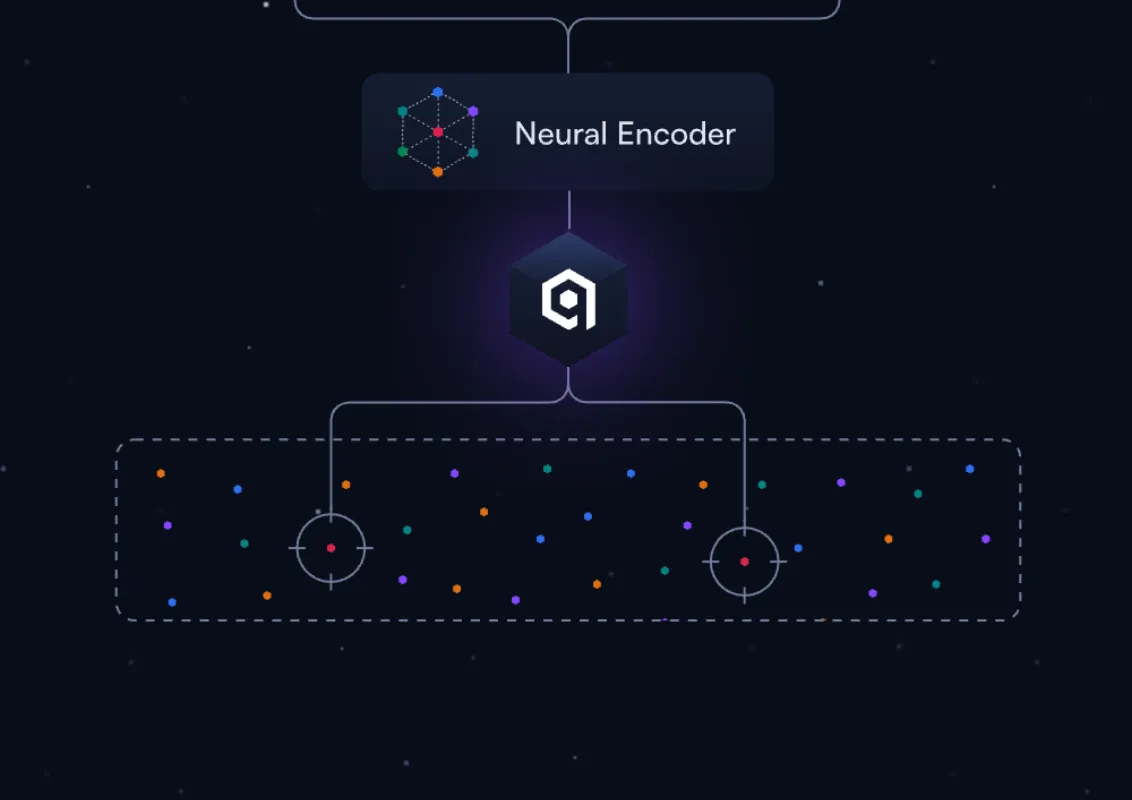

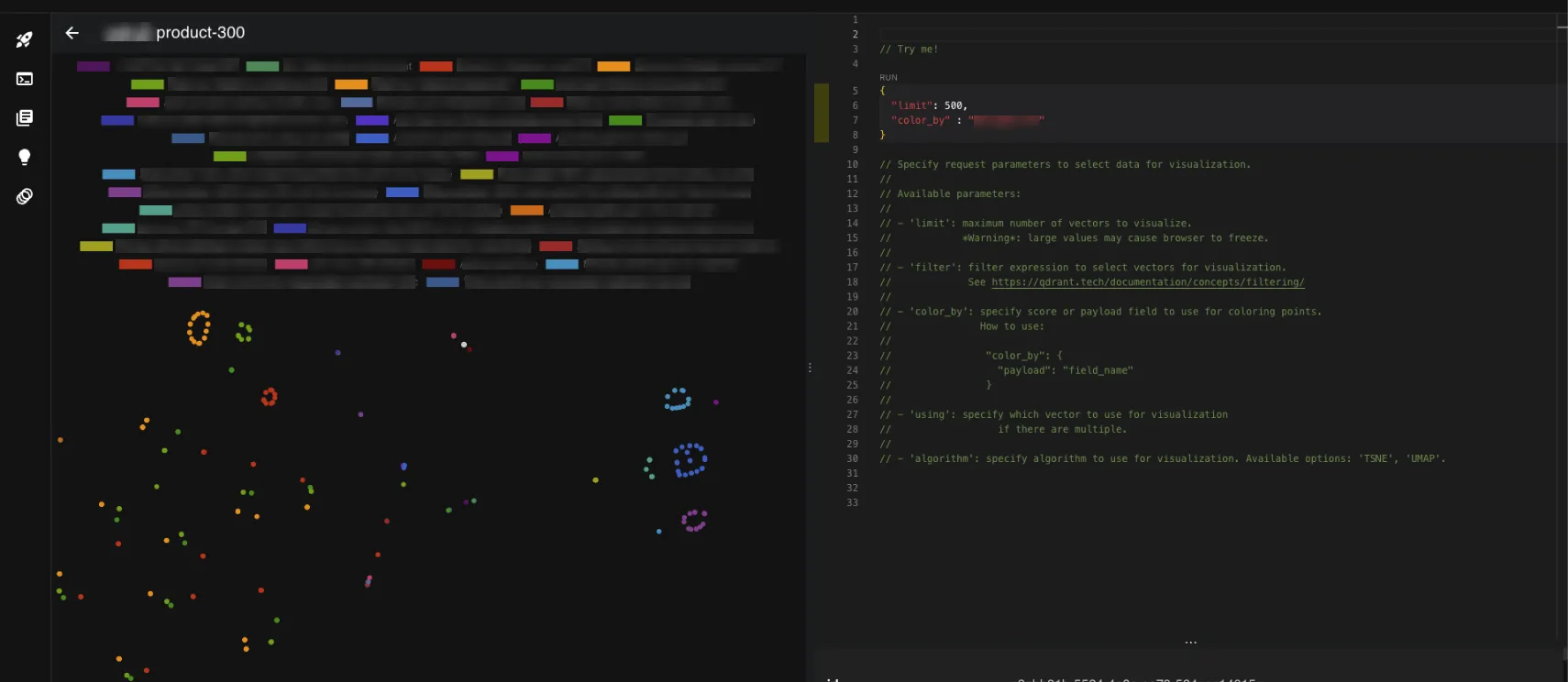

Nous architecturons votre infrastructure de recherche vectorielle avec Qdrant pour des capacités de recherche sémantique avancées.

Qdrant révolutionne la recherche d'information grâce à sa base de données vectorielle haute performance, permettant des recherches par similarité ultra-rapides, une compréhension sémantique profonde et une intégration native avec les modèles d'IA modernes.