Le webscraping fascine, inquiète, intrigue. Derrière ce terme technique se cachent en réalité des solutions concrètes pour collecter, exploiter et transformer la donnée en véritables leviers de croissance pour votre entreprise. Qui n’a jamais rêvé de disposer d’informations fraîches et actionnables sur ses concurrents, son marché ou ses prospects, et tout cela, sans y passer des semaines ?

Mais attention, rien n’est laissé au hasard : technologies avancées, précautions juridiques, stratégies de contournement face aux anti-bots... Suivez le guide. On entre ici dans les coulisses d’une agence de webscraping, là où l’automatisation rime avec performance mais aussi avec responsabilité.

Le webscraping, un marché qui explose : chiffres et tendances

Impossible de passer à côté : le webscraping est en pleine effervescence. À l’échelle mondiale, ce secteur pèsera près de 2 milliards de dollars en 2030, avec aujourd’hui un taux de croissance avoisinant les 14 % annuels.

En France, on assiste aussi à une accélération remarquable : 106,5 millions de dollars prévus en 2035 contre seulement 30 millions en 2024 (Market Research Future, 2025).

Pourquoi ? Parce que l’accès à la donnée, aujourd’hui, fait toute la différence. Stratégies de pricing en temps réel, veille concurrentielle, enrichissement de bases de prospects, analyse de tendances marché… Les entreprises veulent du concret, du rapide, du fiable.

- En Amérique du Nord, la demande explose, portée par la finance et la maturité du cloud

- Les usages autour du suivi des prix et de la concurrence progressent le plus vite (+19,8 % par an)

- L’externalisation auprès d’agences expertes progresse encore plus rapidement que l’achat de logiciels (+15 % par an)

En pratique : comment fonctionne une agence de webscraping ?

Activer le bon levier pour chaque projet

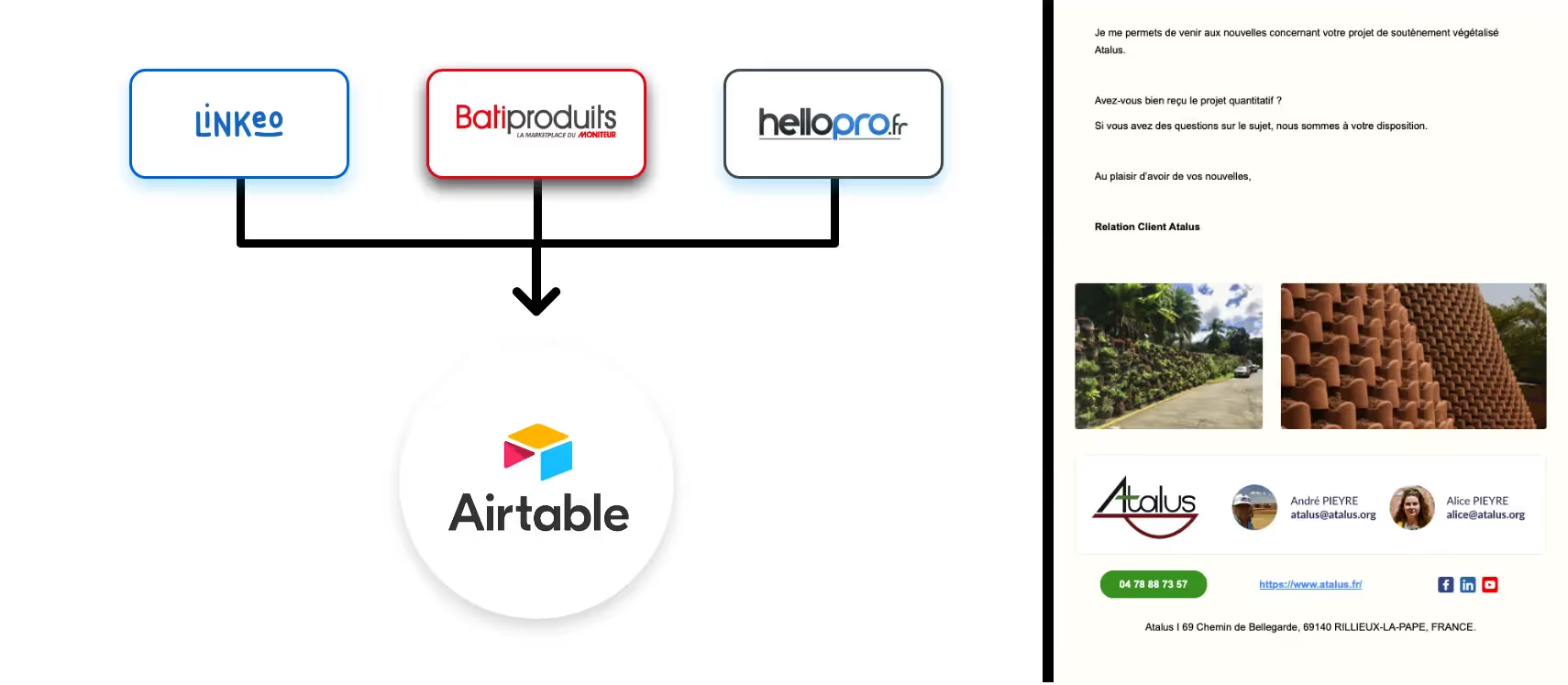

Une agence spécialisée ne se contente pas de “crawler” des pages web à la volée. L’enjeu, c’est de transformer une masse d’informations brutes en données structurées, propres, harmonisées et prêtes à l’action. Chez Mirax, tout commence par la compréhension du besoin client : quoi ? où ? sous quelle forme ? pour quoi faire ? Nous mettons un point d’honneur à identifier, collecter, structurer et exploiter la donnée à chaque étape du projet, via des outils soigneusement choisis.

Les trois temps forts : collecte, structuration, exploitation

1. Collecter : scanner, extraire, agréger

Rien ne sert de tout aspirer… Il faut cibler. L’agence définit d’abord les sources pertinentes (sites e-commerce, annuaires, réseaux sociaux, open data, APIs…). La collecte passe par différents biais :

- Extraction automatisée via scripts Python (Selenium, BeautifulSoup, Playwright, Crawlee…)

- Outils no-code/low-code : Import.io, Octoparse, PhantomBuster, Web Scraper (pour des cas moins complexes)

- Automatisation cloud et utilisation de proxys pour contourner les blocages et scaler

Le choix s’affine en fonction du volume, de la fréquence de collecte, des mécanismes de protection des sites, mais aussi… du cadre légal (on y revient !).

2. Structurer : organiser, nettoyer, sécuriser

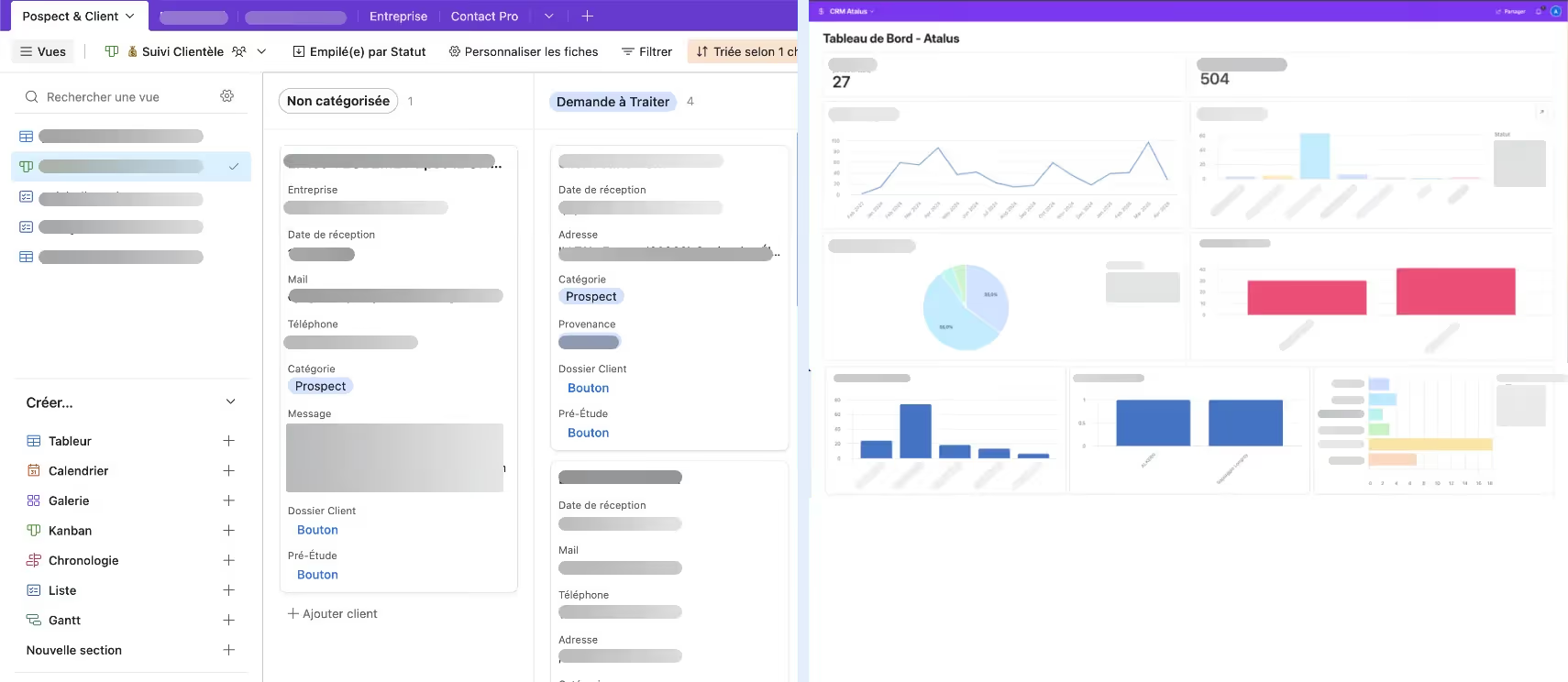

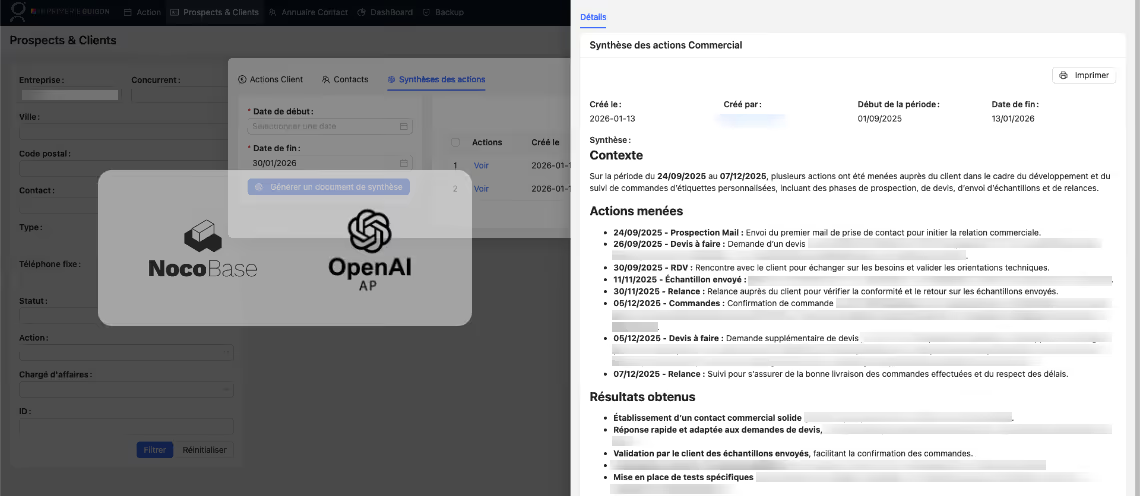

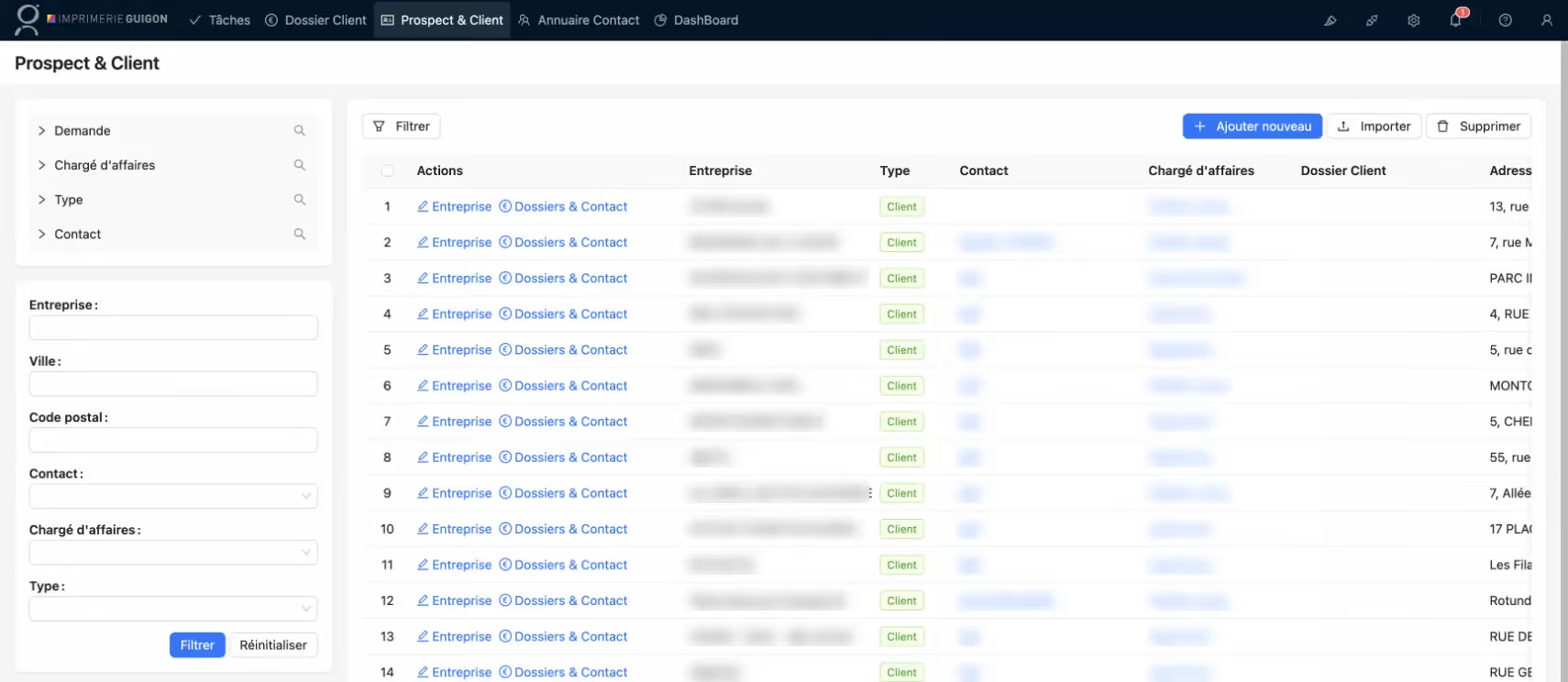

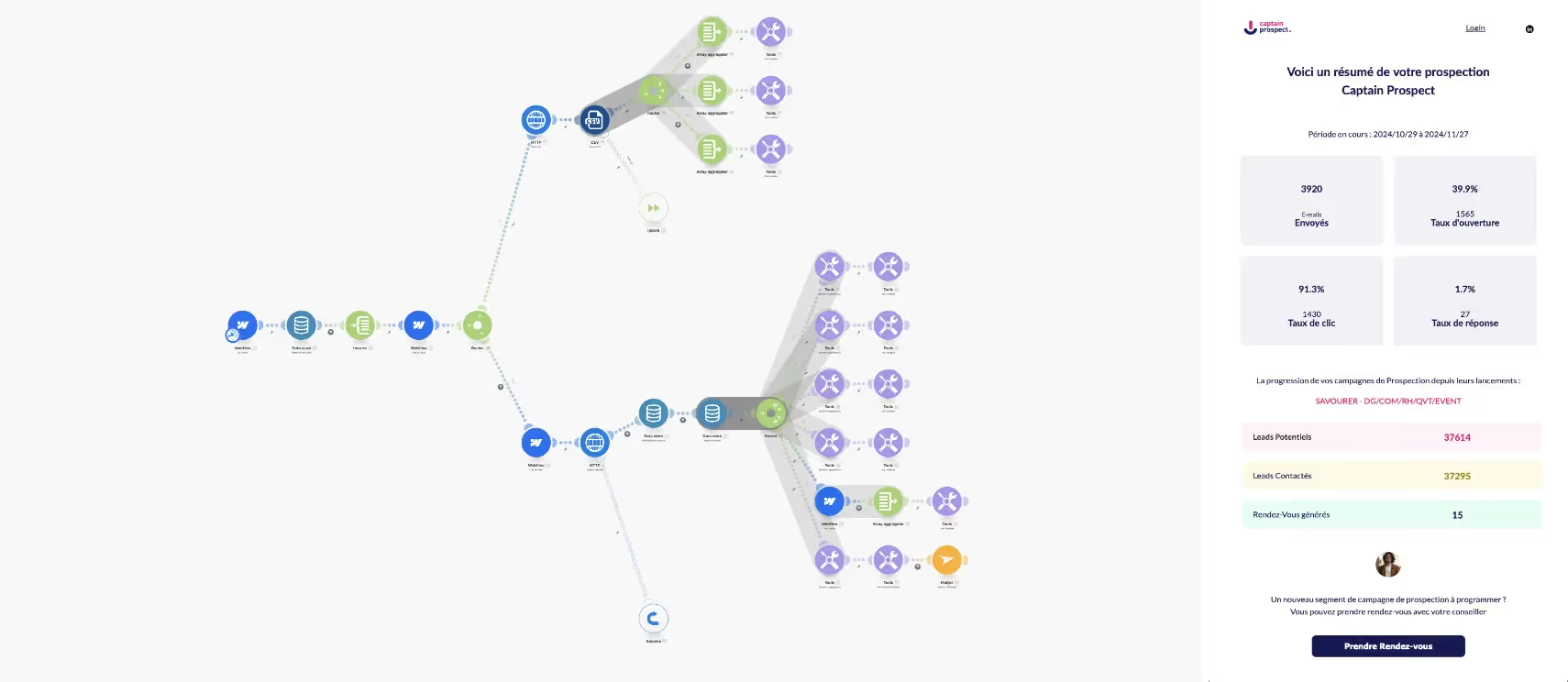

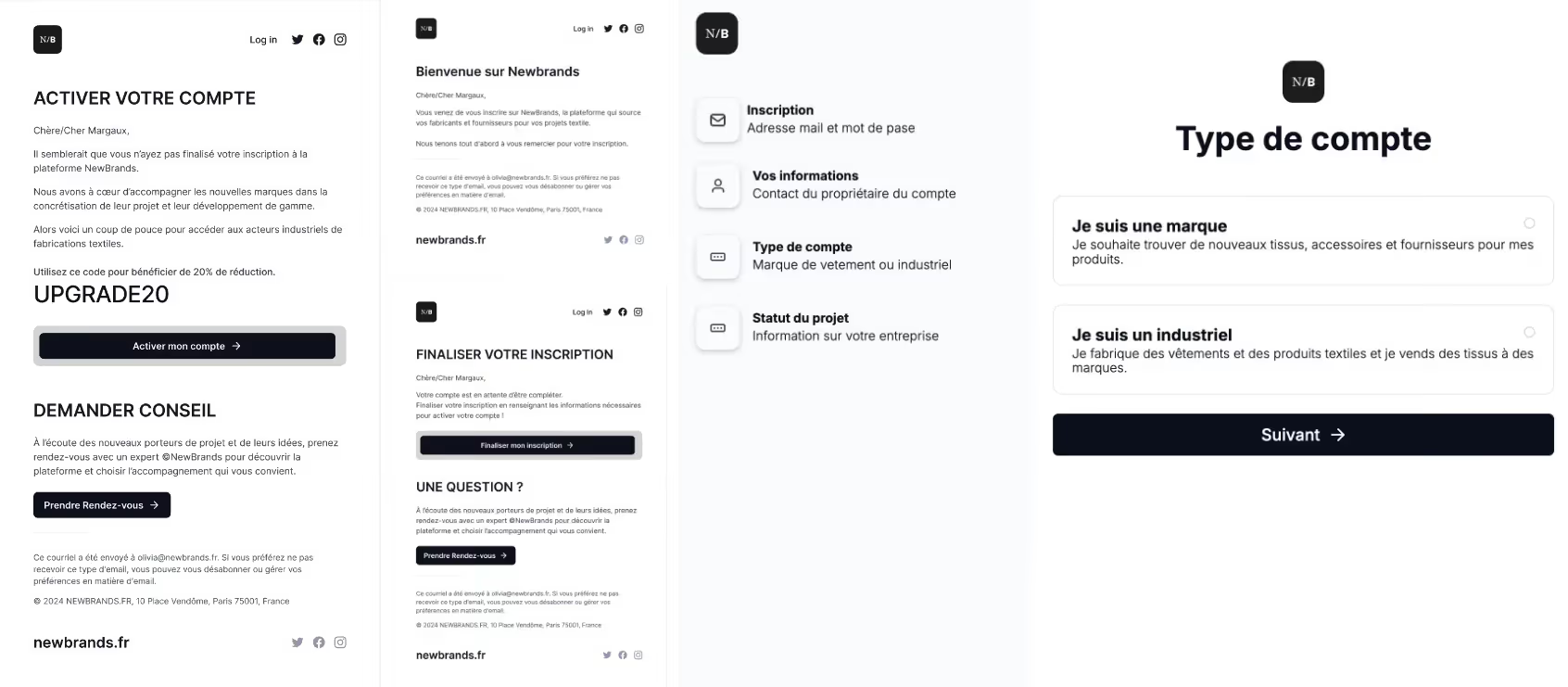

La donnée brute, ce n’est que la première étape. Ici entre en jeu le savoir-faire de l’agence : tri, suppression des doublons, nettoyage, normalisation des formats. Nous structurons vos jeux de données dans des solutions scalables (Google Cloud, AWS, Airtable, BigQuery…). L’objectif : offrir un accès temps réel, une intégration fluide avec votre CRM ou ERP, et une exploitation sans friction. À chaque projet, des automatisations sur-mesure viennent synchroniser, enrichir ou rapprocher les sources (par exemple, connecter des leads LinkedIn avec votre base CRM, ou alimenter une plateforme marketing avec des profils fraîchement détectés).

3. Exploiter : automatiser, visualiser, décider

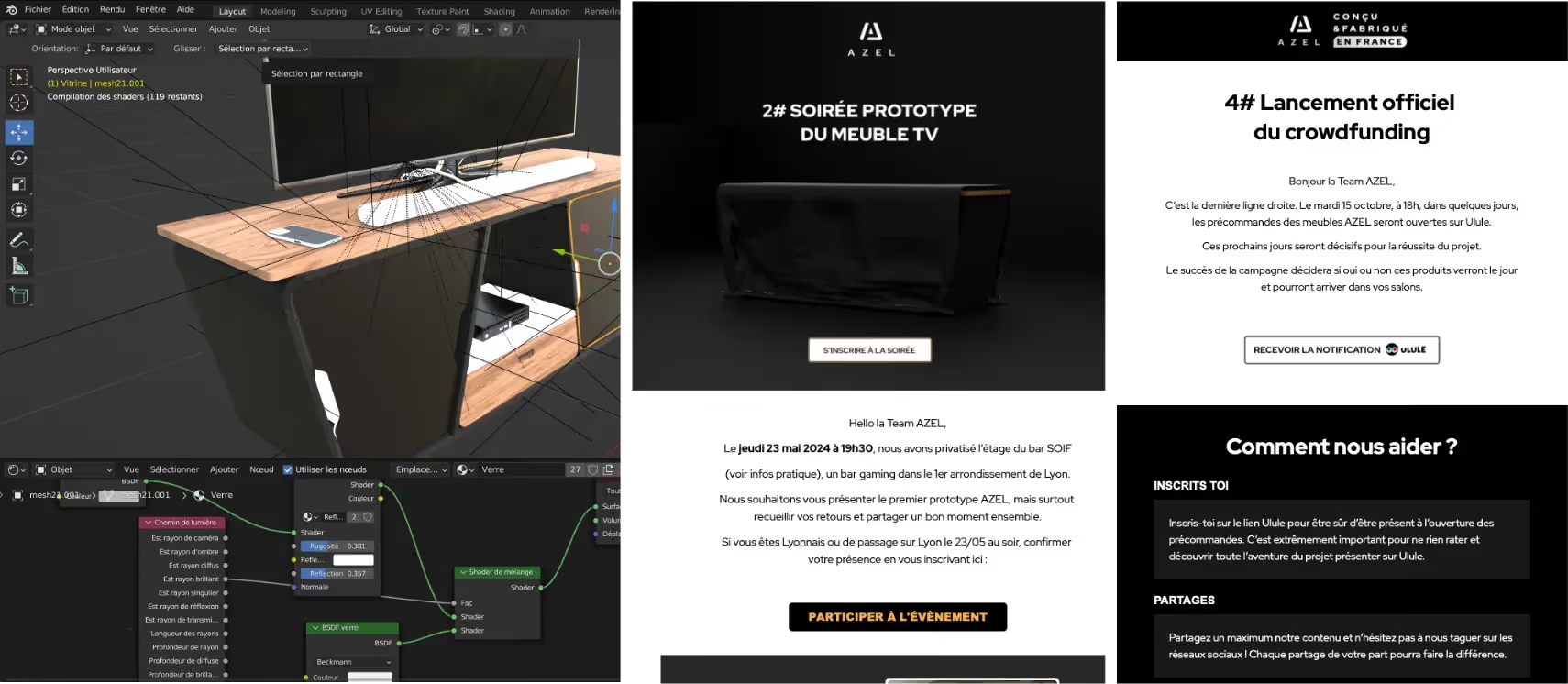

Une expertise parfois sous-estimée ! L’agence transforme la donnée en tableaux de bord interactifs (Google Data Studio, Power BI…), construit des alertes (veille automatisée, scoring de prospects), synchronise avec vos outils internes… Bref, du concret, du sur-mesure : votre activité, vos métriques – en temps réel, accessibles, clairs. Vous souhaitez une relance automatique quand un prospect télécharge un document ? Une remontée quotidienne des nouveaux domaines .fr enregistrés, enrichis avec les coordonnées décisionnaires ? C’est possible – et c’est (souvent) déjà fait chez nos clients :

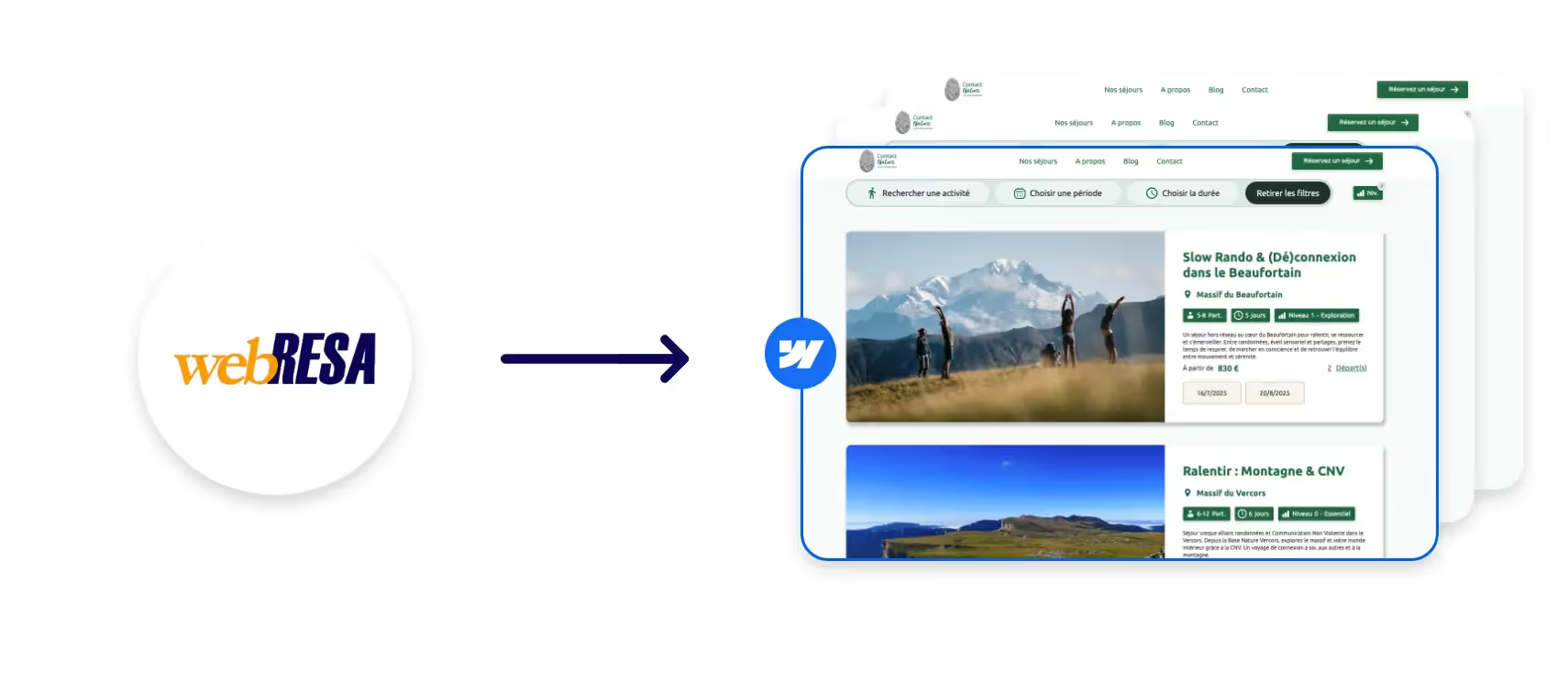

- Tableau de bord Webflow centralisant activité/facturation clients

- Scraping et enrichissement de bases de contacts LinkedIn sur des événements pros ultra-ciblés

- Extraction et formatage automatisé de leads ouverts depuis l’open data ou des APIs métiers

Des exemples d'intégrations sont détaillés sur notre page d'expertise Data Scraping.

Outils de webscraping : arsenal technique et choix stratégiques

Les incontournables du marché

Le duo Python + librairies dédiées domine toujours – rien ne rivalise avec la souplesse, la robustesse et la scalabilité technique d’un stack “fait maison”. Pour les besoins moins spécifiques : les outils no-code (Import.io, WebHarvy, Octoparse) rendent accessible le scraping automatisé à toute entreprise, même sans développeur interne.

- Selenium/BeautifulSoup/Crawlee (Python/JavaScript) : pour du sur-mesure, du séquentiel ou massivement parallèle

- Octoparse, PhantomBuster, Import.io : démarrage rapide, exports CSV/JSON, planification automatique, API natives

- Outils cloud / proxys : gestion de l’IP rotation, multi-session, exécution distante pour “passer sous le radar”

On n’oublie pas les besoins métiers très pointus : API enrichies pour récupérer instantanément les nouveaux domaines .fr déposés (cf. scraper de domaines .fr Mirax), synchronisation directe avec les CRM du marché, et bien sûr, dashboards automatisés consultables par toutes les équipes concernées.

L’automatisation par l’intelligence artificielle

L’IA renverse la donne. Capable de reconnaître et d’adapter en temps réel l’extraction malgré les évolutions de structure des sites, elle augmente la rapidité (jusqu’à 30-40 % de gains sur les collectes massives) et la fiabilité (jusqu’à 99 % de précision). Sans IA, piloter une veille concurrentielle dynamique ou scaler sa prospection multicanal est vite illusoire. Mirax automatise et fiabilise, au service de la performance et de la qualité.

Cadre légal : naviguer entre opportunités et contraintes

RGPD, conditions d’utilisation : ne jamais transiger

La collecte de données n’est pas une zone de non-droit, loin de là. En France comme en Europe, le RGPD et les réglementations sectorielles (banque, santé, secteur public…) obligent les agences à mener des projets “privacy by design” : consentement, anonymisation si besoin, respect strict des conditions d’utilisation, documentation complète de la finalité et des moyens.

- Veille juridique constante – la législation évolue aussi vite que les usages

- Processus d’extraction intégrant pauses aléatoires, comportement “humanisé”, respect des quotas, effacement automatique au-delà de la durée utile

- Accompagnement à la conformité documentaire (traceabilité, audits, réponses aux demandes des autorités…)

Conséquence : sous-estimer ce facteur expose à de lourdes sanctions, financières comme réputationnelles. C’est pourquoi nos scripts et processus sont conçus pour concilier performance, sécurité des accès, et conformité absolue avec chaque cahier des charges.

Gestion active des risques et évolutions sectorielles

Le paradigme change : les solutions externalisées, portées par des agences experts, progressent plus vite que l’achat de logiciels. Pourquoi ? Parce que la complexité du cadre légal, la sophistication des systèmes anti-bot (près de la moitié du trafic web est généré par des robots, avec tous les risques de blocages…) nécessitent un arbitrage agile, une veille constante et des méthodes évolutives.

Concrètement : Mirax délivre des solutions clef-en-main, sécurisées, monitorées, et toujours documentées. Notre parti pris : jamais de scrape qui mettrait en péril votre réputation ou votre légalité. Vos données, oui, mais en toute confiance.

Quand faire appel à une agence de webscraping : situations et bénéfices

Des cas d’usage pour chaque secteur

- Prospection commerciale ponctuelle ou récurrente (veille sur l’achat de domaines, détection de création d’entreprise, identification des décideurs, enrichissement Linkedin)

- Suivi de prix et de concurrence pour les e-commerçants ou les ESN

- Centralisation et nettoyage de données multicritères (CRM, outils métiers, facturation, campagnes emailing…)

- Reporting automatisé et suivi de KPIs pour un pilotage stratégique

Vous voulez des exemples concrets ? Découvrez nos réalisations sur le scraping LinkedIn évènementiel ou l’automatisation de tableaux de bord sur-mesure.

Se lancer : pourquoi choisir une agence experte comme Mirax ?

Un pilotage de A à Z, éthique et sur-mesure

Collecter c’est bien, exploiter c’est mieux et sécuriser, c’est vital. Chaque projet est construit autour de vos objectifs métiers :

- Audit et identification des sources pertinentes

- Mise en place technique – extraction, automatisation, enrichissement sécurisé

- Structuration, visualisation, intégration métier

- Formation ou transfert de compétence si nécessaire (pour les indépendants, entreprises et directions métiers)

Vous gardez la main, on vous garantit la conformité, la fiabilité, la performance. Et tout ça, sans sacrifier la simplicité de prise en main.

En résumé : Le webscraping, c’est un catalyseur de performance, mais un terrain exigeant. Sans expertise technique et vigilance réglementaire, gare aux faux pas. Envie d’en savoir plus ou de tester rapidement un POC adapté à vos besoins ? Contactez-nous, on vous accompagne de A à Z.