Impossible d’y échapper : en 2025, l’IA ne se joue plus seulement dans les laboratoires d’OpenAI ou les keynotes de Google. Elle s’invite au cœur des PME, des ETI, des équipes terrain. Exit la boîte noire inaccessible : la vague des LLM open source – symbolisée par la disponibilité de modèles “poids ouverts” comme gpt-oss-120b ou Llama 3 – dessine un nouveau paysage. Plus agile, plus transparent, souvent (bien) moins cher, surtout taillé pour les vrais besoins métier.

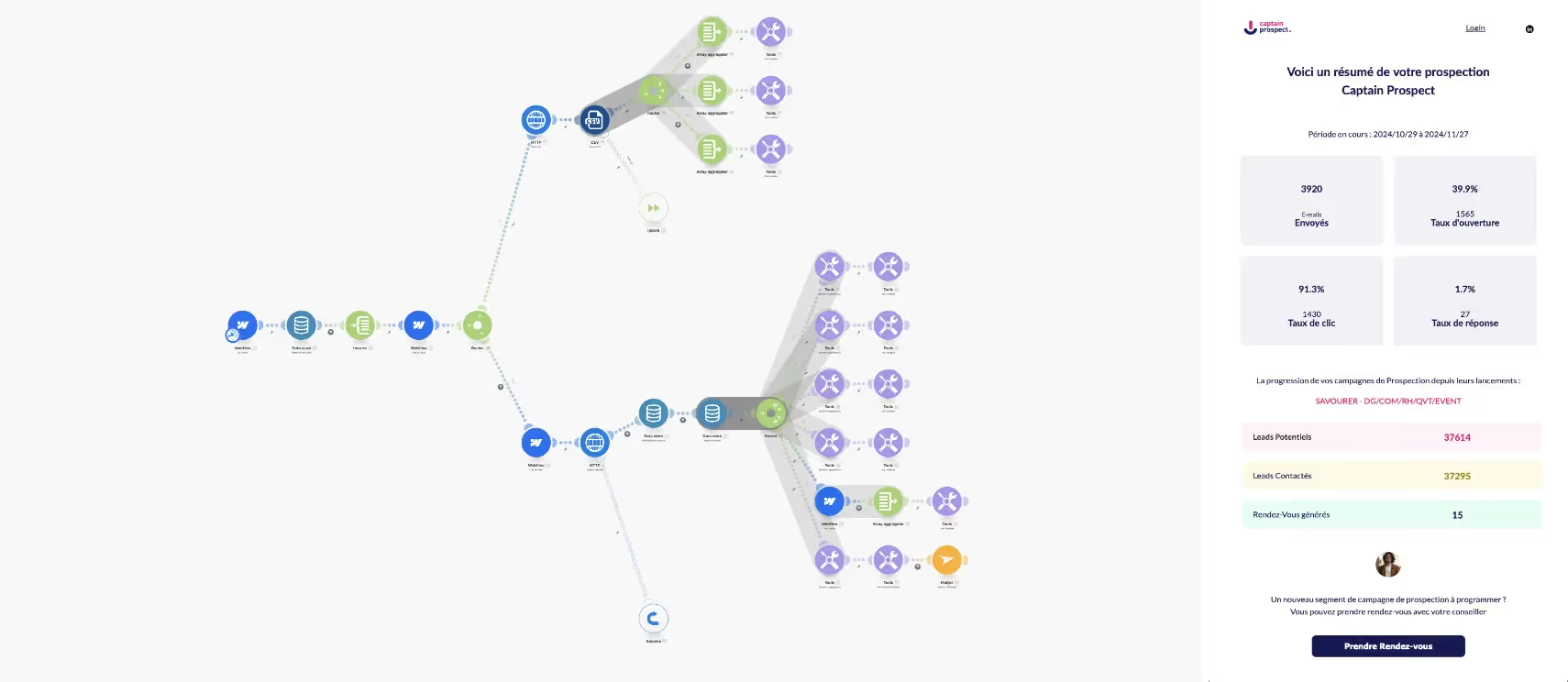

Chez Mirax, on constate chaque semaine la montée en puissance et le ROI : la révolution est bien lancée, et elle s’organise autour d’un nouveau triptyque : personnalisation, sécurité, souveraineté. Mais concrètement, pourquoi les LLM open-weight changent tout ? Et comment franchir ce cap sans se tromper ?

LLM open source : la lame de fond de 2025

En chiffres, l’histoire parle d’elle-même. D’ici la fin de l’année, 67 % des entreprises mondiales auront intégré un LLM dans leurs process quotidiens. Plus qu’une vague, un raz-de-marée. Signe fort : ce sont désormais les solutions “open source” qui tirent la croissance, représentant plus de la moitié du marché des LLM déployés en interne. Commerce de détail, e-commerce, santé, legal, back office… tous s’y mettent.

Il y a une logique simple derrière cette ruée : là où ChatGPT posait hier les jalons du grand public, l’open source pousse la porte de la personnalisation à coût (très) mesuré.

En 2025, le monde de l’IA générative ne se limite plus à dupliquer ce que font les géants. Il s’agit d’inventer, d’ajuster, d’intégrer parfois à la virgule près le langage et les process d’un métier, d’une région, d’une équipe.

- Marché du LLM en 2025 : valeur estimée à 82,1 milliards $ d’ici 2033, dont la moitié open source sur déploiement local

- Plus de 750 millions d’applications s’appuient déjà sur un LLM

- ChatGPT : 180 millions d’utilisateurs, mais talonné par les alternatives customisées open source (n8n Blog)

- Presque deux fois plus de nouveaux modèles open source lancés depuis 2023 que de modèles propriétaires

Les modèles qui font la différence

Parmi les fibres les plus actives : Llama 3 (Meta), Mistral (Mistral AI), gpt-oss-120b (OpenAI), Falcon 3, DeepSeek V3… Chacun a ses points forts, mais tous convergent vers une même promesse : offrir une puissance de calcul, une fenêtre contextuelle et des options d’intégration autrefois réservées à quelques élus.

- Llama 3 : context window jusqu’à 128K tokens, multilingue avancé, communauté hyper-active

- gpt-oss-120b : performance quasi équivalente à OpenAI o4-mini, exécution sur un seul GPU 80 Go, licence Apache 2.0

- Mistral : scalabilité, usage edge, code, image, et API mature

- DeepSeek V3, Falcon 3, Command R, Qwen2.5… chacun sa spécialité mais tous accessibles, adaptables, documentés

Pourquoi ces modèles open source cartonnent ?

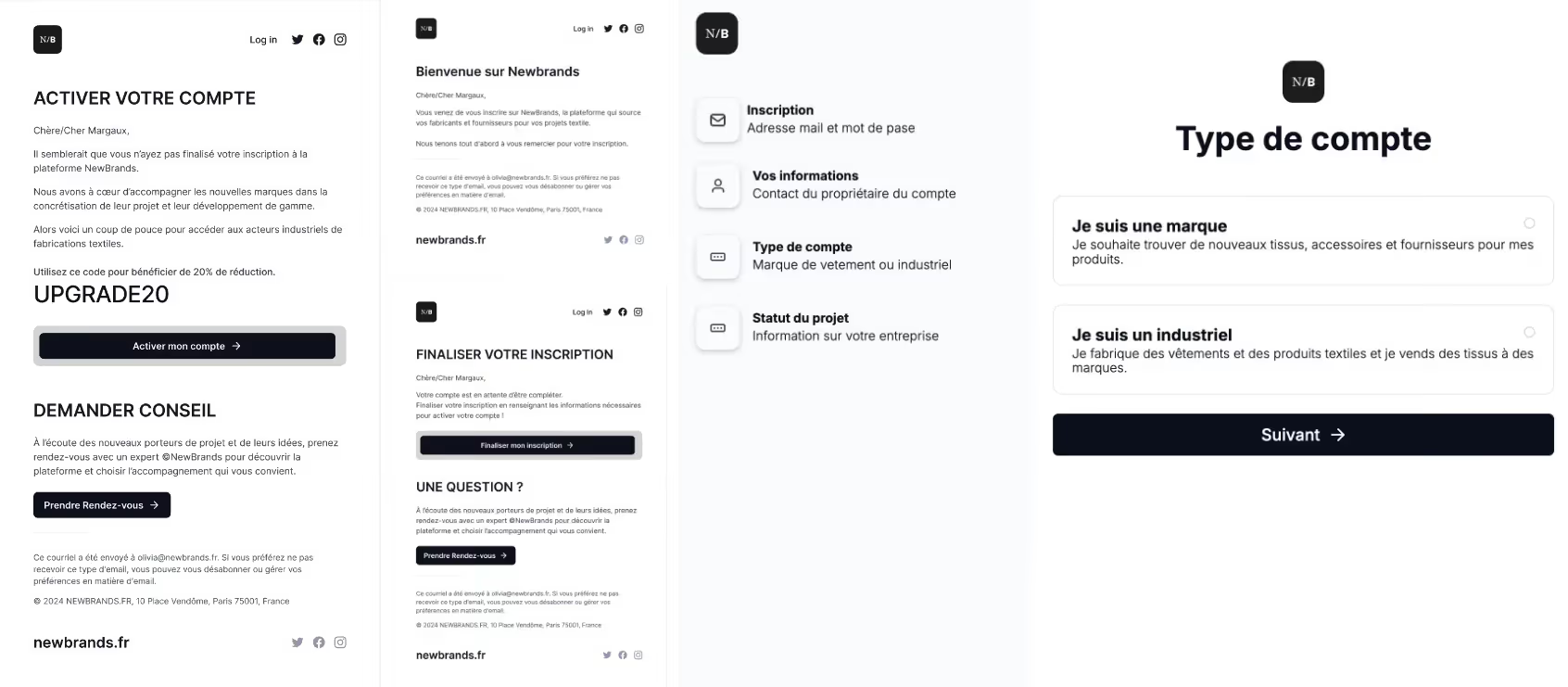

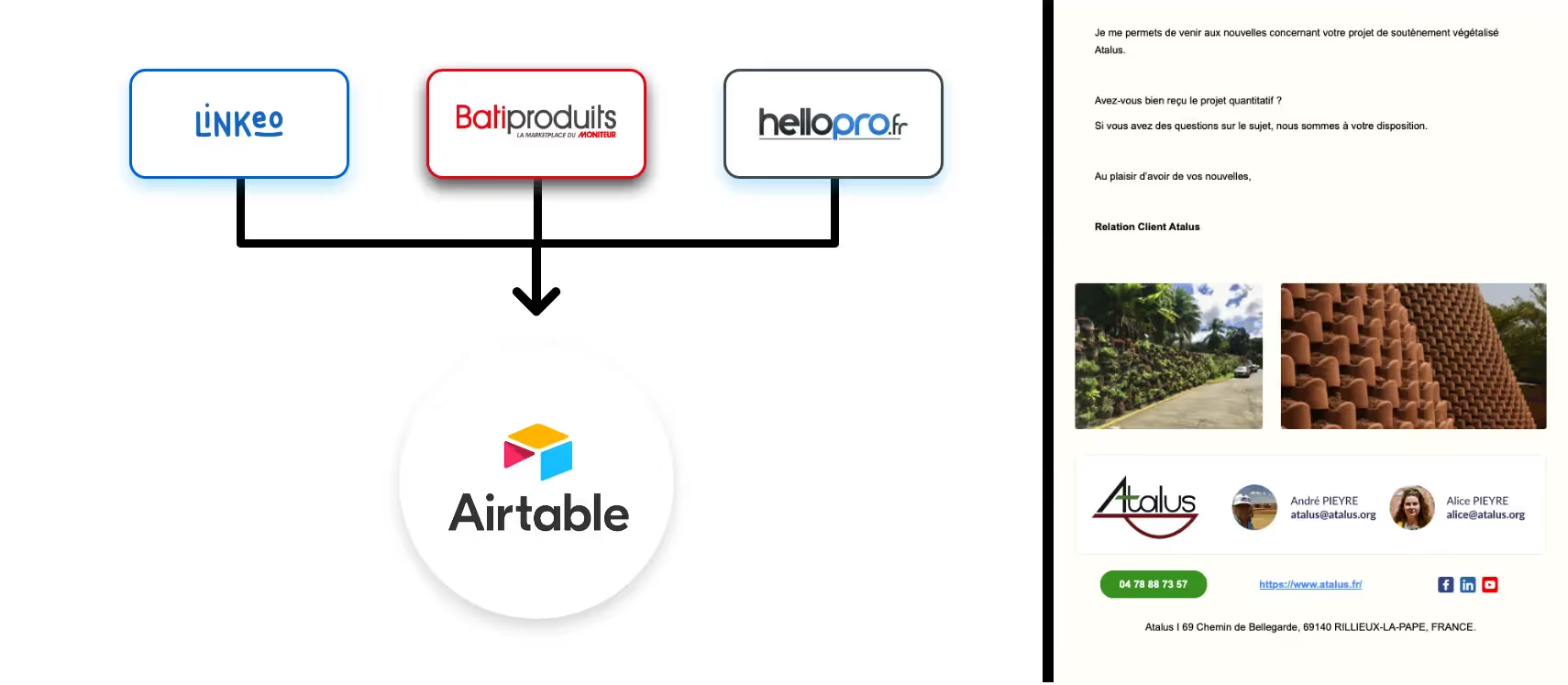

Flexibilité sur-mesure et maîtrise des coûts

Ce n’est pas un secret : automatiser un support RH interne ou lancer une chaîne d’analyse médicale avec ChatGPT “vanille”, c’est souvent toucher vite ses limites… ou exploser le budget. Les LLM open source (gpt-oss, Llama, Mistral, etc.) prennent ici une longueur d’avance. On leur injecte vos données, votre jargon, vos règles métier – et le modèle devient soudain le copilote dont rêvait votre équipe.

Argument massue ? Coût divisé jusqu’à 100x selon la taille du modèle et le scénario de déploiement. Licence permissive (Apache 2.0, CC-BY), pas de commission sur la revente ni de “bad surprise” sur les droits d’exploitation de votre IA personnalisée.

Transparence, souveraineté et conformité

Plus question d’être pieds et poings liés à un fournisseur unique. Avec l’open source : vous voyez tout, vous ajustez tout, vous hébergez où vous voulez. Besoin d’une IA RGPD, hébergée localement pour cause de données sensibles ? C’est simple, on déploie Llama ou gpt-oss on-premise, on contrôle les flux API, on applique le chiffrement, le monitoring, on trace chaque accès.

C’est la même dynamique sur la sécurité. Les modèles open-weight récents (ex : gpt-oss-120b) bénéficient des meilleures pratiques d’OpenAI en cleaning dataset, évaluation anti-abus et alignement. Le tout audité par des tiers et ouvert à la contribution — la recherche progresse plus vite, et pour tout le monde.

Dynamique communautaire et innovation

Le progrès appartient à ceux qui partagent : la communauté mondiale fourmille d’experts qui benchmarkent, adaptent, affinent chaque release. Résultat : support, tuto, correctifs, nouvelles fonctionnalités arrivent à la vitesse de l’éclair… Y compris pour corriger d’éventuelles failles de sécurité.

Sans compter les frameworks ouverts — Hugging Face, DeepSpeed, PEFT, OpenLLM, etc. — qui multiplient les usages métier et accélèrent la R&D.

Du généraliste au spécialiste : l’heure du fine-tuning

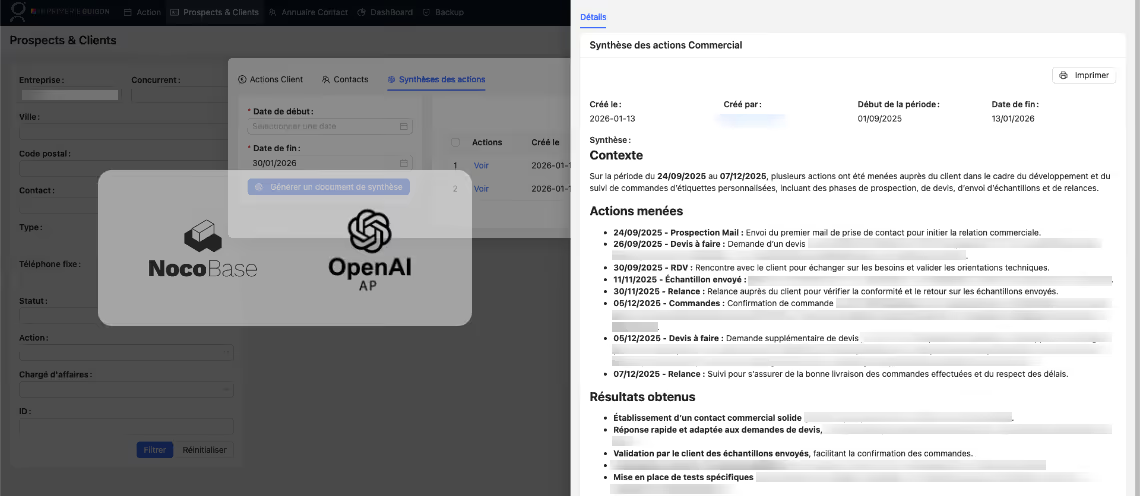

Oubliez les réponses à moitié pertinentes et les chatbots “passe-partout”. La clé du retour sur investissement, c’est la spécialisation. Chez Mirax, notre conviction est simple : la vraie valeur de l’IA ne se révèle que quand vos workflows, vos conventions, vos contraintes s’imposent à l’algorithme.

La méthode Mirax pour des LLM vraiment utiles

- Choisir le bon modèle (taille, licence, compatibilité hardware)

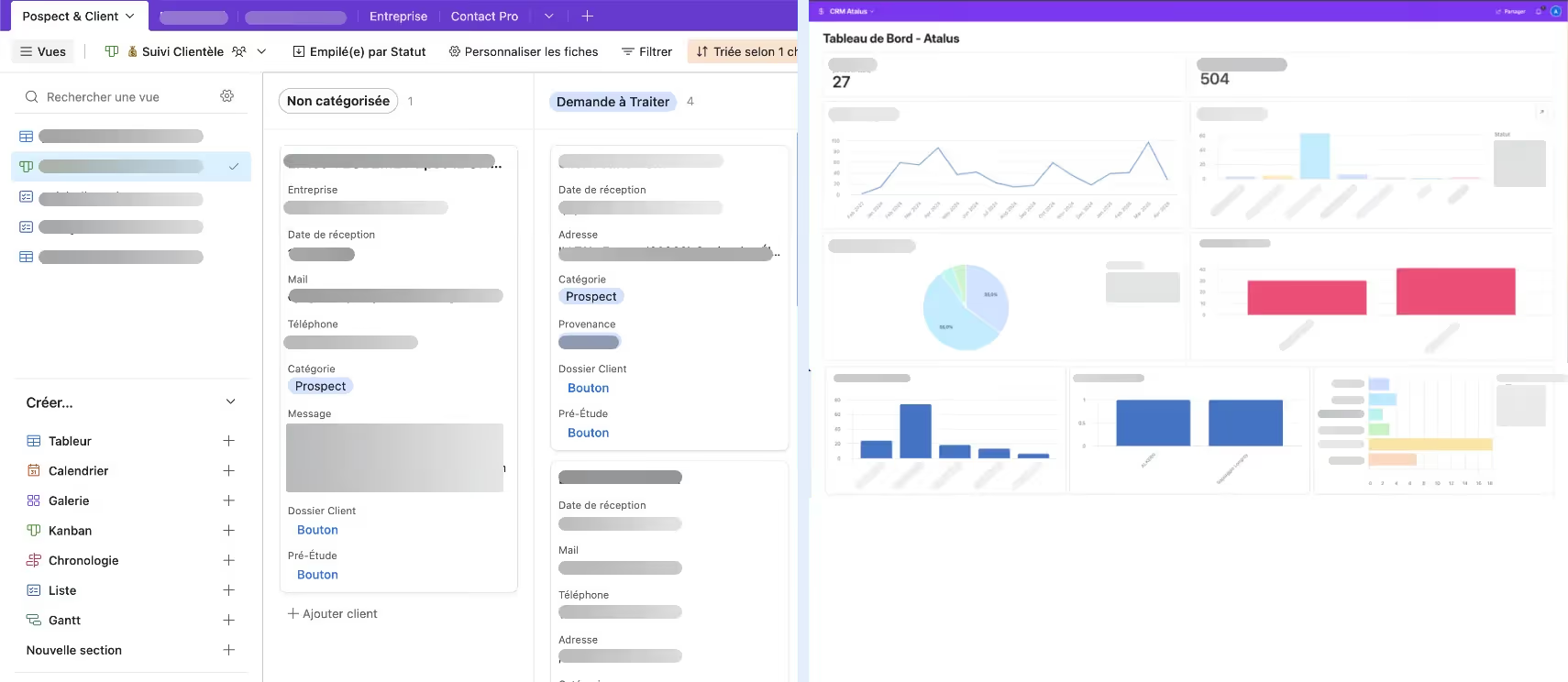

- Définir le niveau de personnalisation : RAG pour de la FAQ dynamique, fine-tuning pour les logiques critiques

- Collecter, structurer, anonymiser vos données à fort impact métier

- Réaliser un fine-tuning robuste : LoRA, QLoRA, adapters, le tout validé terrain

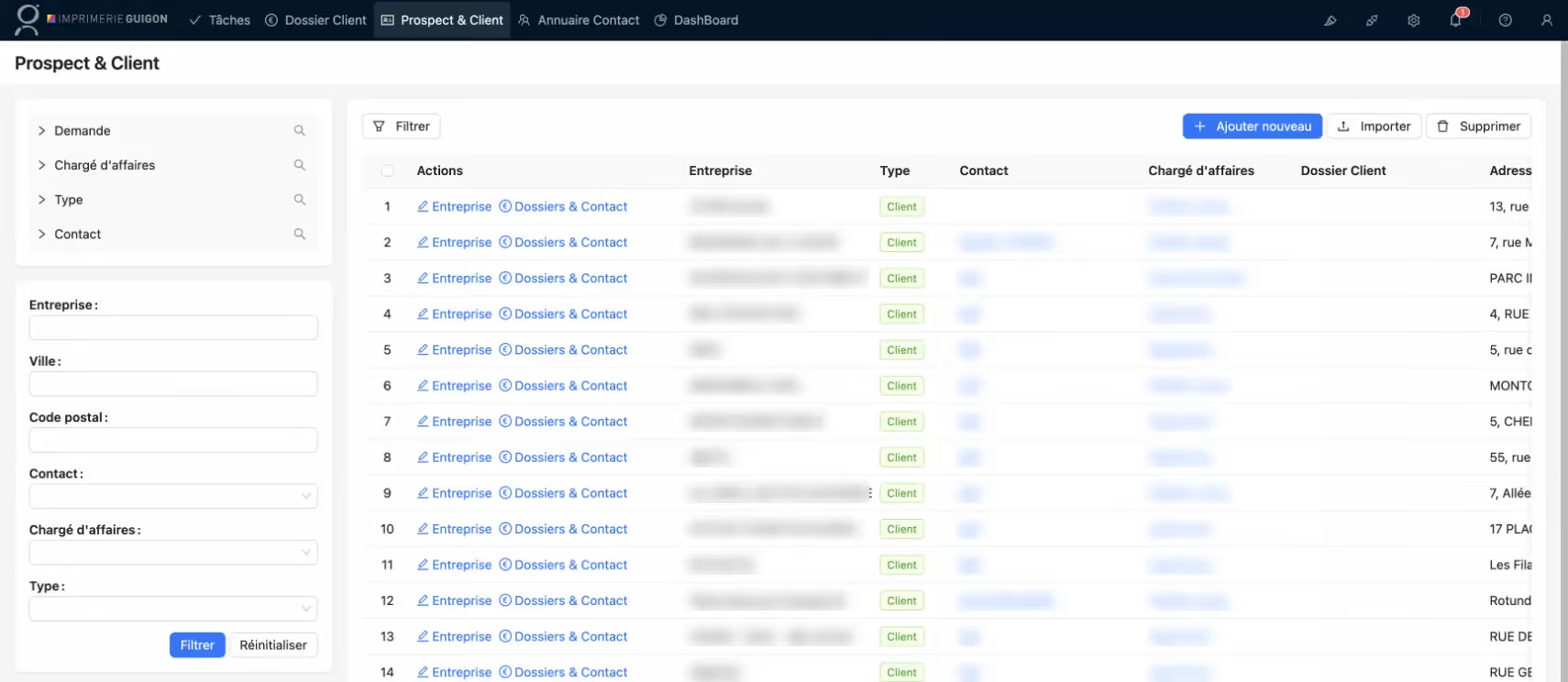

- Optimiser le déploiement : middleware sécurisé, connexion à vos SI (CRM : voir nos intégrations API), logs de traçabilité, conformité RGPD

- Mesurer et itérer en continu : satisfaction, gain de temps, réduction erreur

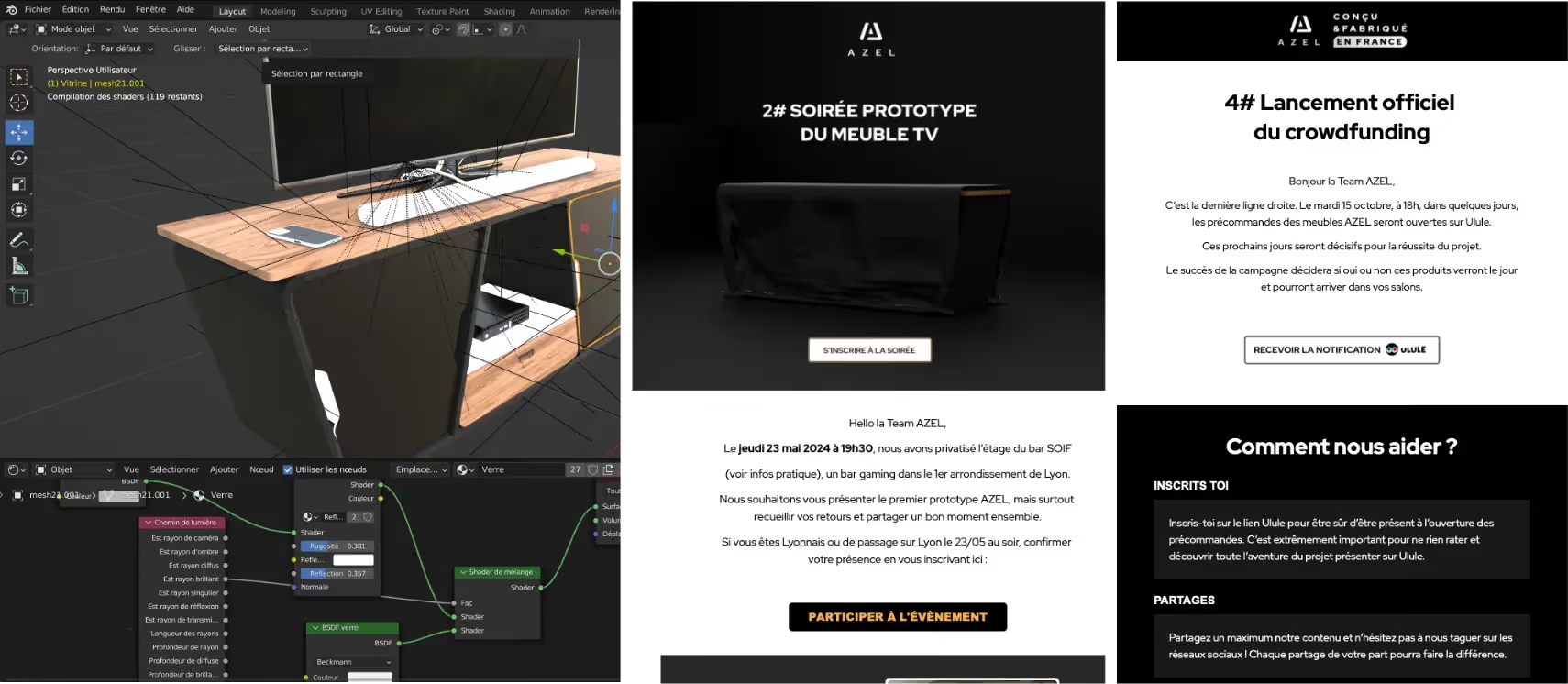

Le cas gpt-oss-120b : sobriété et performance main dans la main

Ce modèle, tout droit sorti des équipes OpenAI, met une claque aux idées reçues : exécution possible sur un seul GPU de 80 Go (voire moins avec quantization), approche Mixture-of-Experts pour réduire les besoins de calcul (seuls 5,1 milliards de paramètres activés par jeton). Performance au top, latence maîtrisée, fenêtres de contexte XXL jusque 128 000 tokens !

En pratique ? Génération, synthèse, analyse de documents longs ; reporting RH sur 40 conventions ; moteur d’aide à la décision ; copilote médical doté d’un raisonnement par chaîne de pensée. En prime : des niveaux de raisonnement ajustables et la possibilité d’intégrer – ou non – des outils contextuels pour gagner encore en pertinence.

Autre détail qui compte : sécurité native, audits tiers et un engagement fort dans la publication d’outils d’orchestration open source, Python/Rust, quantification MXFP4, et compatibilité avec tous les grands clouds et solutions IA du marché.

Les défis à anticiper : maturité, sécurité, gouvernance

La tentation du “plug and play” est grande. Pourtant, tout miser sur un modèle open source sans cadrage métier ou sécurisation, c’est risquer l’échec. Chez Mirax, on accompagne la montée en puissance en verrouillant chaque maillon : gouvernance des données (RGPD, audit, anonymisation), déploiement incrémental (POC, MVP, pilotage modulaire), formation des équipes (voir nos formations IA).

Certaines limites persistent : maturité inégale selon les modèles, fiabilité perfectible sur des tâches hyper spécialisées, et un vrai enjeu d’audit en continu pour éviter toute dérive, hack ou fuite de données critiques. La bonne nouvelle ? La plupart des acteurs du secteur, Google, Meta, OpenAI mais aussi la communauté open source, publient régulièrement benchmarks, leaderboard et correctifs. L’amélioration est constante.

FAQ rapide pour dirigeants et responsables IT

- “Faut-il être une multinationale pour bénéficier du fine-tuning ?” Non ! PME, ETI, secteur public, chaque structure qui veut ancrer de la valeur dans ses process y trouve son compte (exemple : automatisation devis, chatbot RH spécialisé, moteur d’analyse médicale localisé).

- La sécurité est-elle au niveau ? Oui, à condition de piloter l’intégration technique et de choisir un partenaire expert. Les modèles récents (gpt-oss-120b, Llama 3) sont soumis à un entraînement rigoureux et audités pour limiter les risques.

- Combien de temps et de budget ? Souvent, de 2 à 6 semaines pour un projet borné, à un coût divisé par 10 à 100 par rapport à une solution propriétaire équivalente.

Conclusion : la révolution des LLM open source, on la vit — pas demain, maintenant

2025. Fini le temps où l’IA métier était réservée aux géants de la Tech ou aux gros budgets R&D. Désormais, vos outils parlent votre langue, respectent vos règles, et innovent… sans plafonner le ROI. Flexibilité, souveraineté, rapidité d’itération : la vague open source ne fait que commencer et elle bouscule tout le secteur.

Prêt à franchir le cap ?

Débloquez la puissance de l’IA générative métier, testez, affinez, spécialisez.

On en parle ? Fixons un rendez-vous pour dessiner ensemble votre prochain virage IA. Ou explorez nos réalisations IA et automatisation pour vous inspirer.

La révolution est en marche. À vous d’en saisir les rênes !